1. 背景介绍

1.1 AI大语言模型的崛起

近年来,随着深度学习技术的快速发展,AI大语言模型逐渐成为了人工智能领域的研究热点。从OpenAI的GPT系列模型,到Google的BERT、T5等模型,这些大型预训练模型在自然语言处理任务上取得了显著的成果,甚至在某些任务上超越了人类的表现。

1.2 知识图谱的重要性

知识图谱作为一种结构化的知识表示方法,可以有效地存储和管理大量的实体、属性和关系信息。知识图谱在很多领域都有广泛的应用,如智能问答、推荐系统、知识管理等。然而,知识图谱的构建和维护通常需要大量的人工劳动,这限制了知识图谱的规模和实时性。

1.3 融合的必要性

AI大语言模型和知识图谱各自在自然语言处理和知识表示方面取得了显著的成果,但它们之间仍存在一定的鸿沟。通过将二者融合,我们可以充分发挥它们的优势,实现更高效的知识获取、表示和推理。本文将探讨AI大语言模型与知识图谱的融合方法,以及未来的发展趋势和挑战。

2. 核心概念与联系

2.1 AI大语言模型

AI大语言模型是一种基于深度学习的自然语言处理模型,通过在大量文本数据上进行预训练,学习到丰富的语言知识。这些模型通常采用Transformer架构,具有强大的表示学习和生成能力。

2.2 知识图谱

知识图谱是一种结构化的知识表示方法,通常采用图结构来表示实体、属性和关系。知识图谱可以有效地存储和管理大量的知识信息,支持复杂的知识推理和查询。

2.3 融合方法

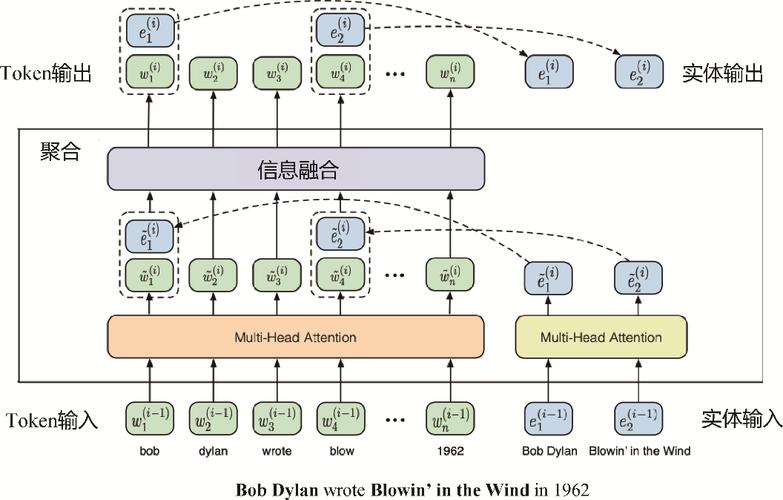

融合AI大语言模型与知识图谱的方法主要有两种:一是将知识图谱中的知识引入大语言模型的预训练过程,使模型能够更好地理解和表示结构化知识;二是将大语言模型的生成能力应用于知识图谱的构建和补全,提高知识图谱的规模和实时性。

3. 核心算法原理和具体操作步骤以及数学模型公式详细讲解

3.1 引入知识图谱的预训练方法

3.1.1 实体嵌入

实体嵌入是一种将知识图谱中的实体表示为低维向量的方法。给定一个知识图谱$G=(E, R, T)$,其中$E$是实体集合,$R$是关系集合,$T$是三元组集合,我们的目标是学习一个映射函数$f: E \rightarrow \mathbb{R}^d$,将实体映射到$d$维向量空间。

常用的实体嵌入方法有TransE、DistMult等。以TransE为例,其核心思想是将三元组$(h, r, t)$中的关系$r$表示为向量空间中的平移操作,即$h + r \approx t$。TransE的损失函数定义为:

$$ L = \sum_{(h, r, t) \in T} \sum_{(h', r', t') \in T'} [d(h + r, t) - d(h' + r', t') + \gamma]_+ $$

其中$d(\cdot, \cdot)$表示向量间的距离度量,如欧氏距离或余弦距离,$[x]_+ = \max(0, x)$表示hinge损失,$\gamma$是一个正的margin参数,$T'$是负采样三元组集合。

3.1.2 预训练任务设计

为了将知识图谱中的知识引入大语言模型的预训练过程,我们可以设计一些特定的预训练任务。例如,给定一个实体对$(h, t)$,模型需要预测它们之间的关系$r$;或者给定一个实体和一个关系$(h, r)$,模型需要预测目标实体$t$。这些任务可以通过修改大语言模型的输入和输出格式来实现。

以BERT为例,我们可以将实体对$(h, t)$表示为一个特殊的句子对,如"[CLS] h [SEP] t [SEP]",并将关系$r$表示为一个特殊的标签。在预训练过程中,模型需要根据输入的句子对预测对应的关系标签。这可以通过在BERT的输出层添加一个分类器来实现,如下所示:

$$ P(r|h, t) = \text{softmax}(W \cdot \text{BERT}(h, t) + b) $$

其中$W$和$b$是分类器的参数,需要在预训练过程中学习。