【AI大数据计算原理与代码实例讲解】Spark SQL

文章目录

- 【AI大数据计算原理与代码实例讲解】Spark SQL

-

- 1. 背景介绍

-

- 1.1 大数据处理的挑战

- 1.2 Spark的诞生

- 1.3 Spark SQL的提出

- 2. 核心概念与联系

-

- 2.1 DataFrame与Dataset

- 2.2 Spark SQL的运行架构

- 2.3 Spark SQL与Hive的关系

- 3. 核心算法原理与具体操作步骤

-

- 3.1 DataFrame/Dataset的创建

- 3.2 DataFrame/Dataset的操作

- 3.3 Catalyst优化器原理

- 4. 数学模型和公式详细讲解举例说明

- 5. 项目实践:代码实例和详细解释说明

-

- 5.1 准备数据

- 5.2 读取数据

- 5.3 数据清洗

- 5.4 数据分析

- 5.5 结果展示

- 6. 实际应用场景

-

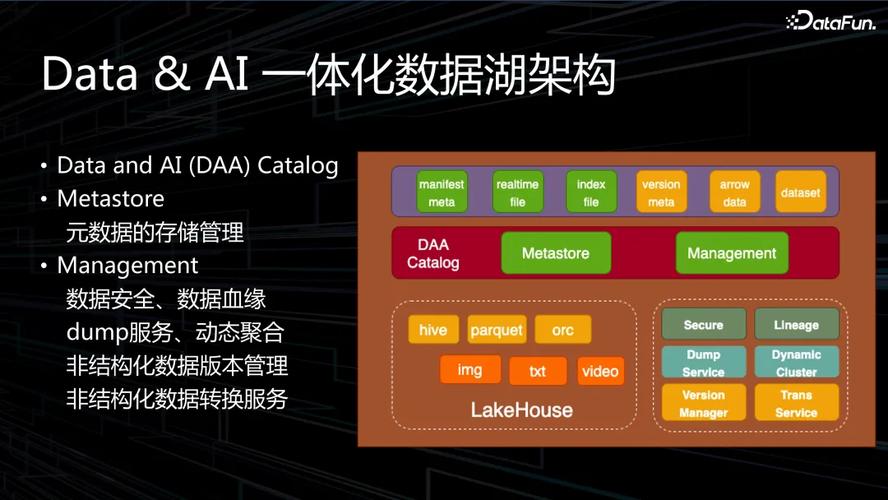

- 6.1 数据仓库

- 6.2 数据湖分析

- 6.3 数据ETL

- 6.4 机器学习

- 7. 工具和资源推荐

- 8. 总结:未来发展趋势与挑战

-

- 8.1 未来发展趋势

- 8.2 挑战

- 9. 附录:常见问题与解答

-

- 9.1 如何安装和配置Spark SQL?

- 9.2 如何优化Spark SQL的性能?

- 9.3 如何处理数据倾斜问题?

- 9.4 如何进行数据格式转换?

- 9.5 如何处理缺失数据?

1. 背景介绍

1.1 大数据处理的挑战

在当今大数据时代,海量数据的存储和处理给传统的数据处理方式带来了巨大挑战。企业需要从海量数据中快速获取有价值的信息,以支持业务决策和创新。然而,传统的数据处理技术如关系型数据库,在面对TB甚至PB级别的数据时,在性能和扩展性方面都显得力不从心。

(图片来源网络,侵删)

1.2 Spark的诞生

为了应对大数据处理的挑战,加州大学伯克利分校的AMP实验室在2009年开始了Spark研究项目。Spark最初是作为Hadoop MapReduce的替代方案而开发的,其目标是提供一个更快、更通用的大数据处理平台。经过多年发展,Spark已经成为了大数据处理领域的事实标准,被广泛应用于各行各业。

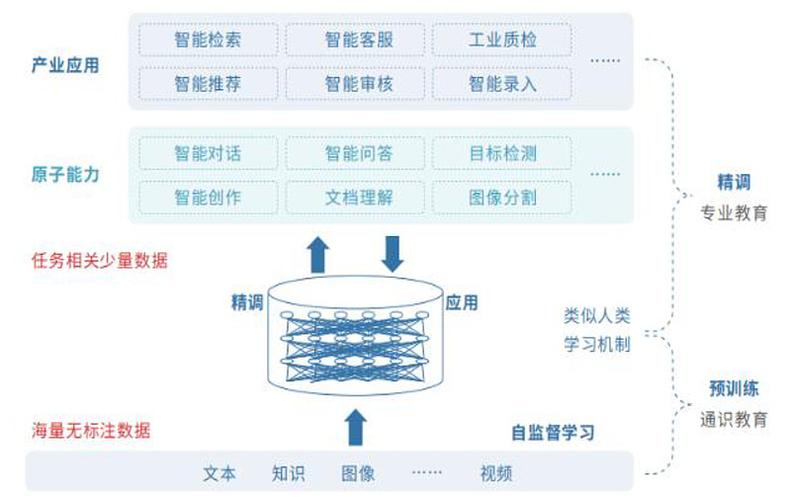

1.3 Spark SQL的提出

Spark SQL是Spark生态系统中的一个重要组件,它建立在Spark之上,为Spark提供了结构化数据处理的能力。Spark SQL的提出,源于人们对于大数据分析中使用类SQL交互方式的强烈需求。相比编写复杂的代码,数据分析师更习惯使用SQL这种声明式语言来描述数据分析逻辑。Spark SQL正是为了满足这一需求而诞生的。

(图片来源网络,侵删)

2. 核心概念与联系

2.1 DataFrame与Dataset

DataFrame和Dataset是Spark SQL中最核心的数据抽象,它们为用户提供了高层次的结构化API: