在跟公司算法工程师交流后,鄙人认为对读过的文章进行总结性文章的发布是有必要的:一来可以巩固和反思、二来可以跟博客的读者们一起学习探讨、三来有助于系统化对此文章的认识。

遂再次续更

一、前言

医学图像分割任务往往数据集很少,所以考虑对模型架构进行变化使得模型能够适应这种少数据量的任务是很关键的。

U-Net: Convolutional Networks for Biomedical Image SegmentationU-Net是一个很经典的医学图像分割模型,其网络结构的信息流呈现一个U状,所以得名。

可以在单个GPU上推理512 * 512大小的医学图像分割(实例和语义)。

笔者最近入坑医学图像处理领域,随阅读之并做一个理解性的学习资料的总结。

二、架构和设计思路

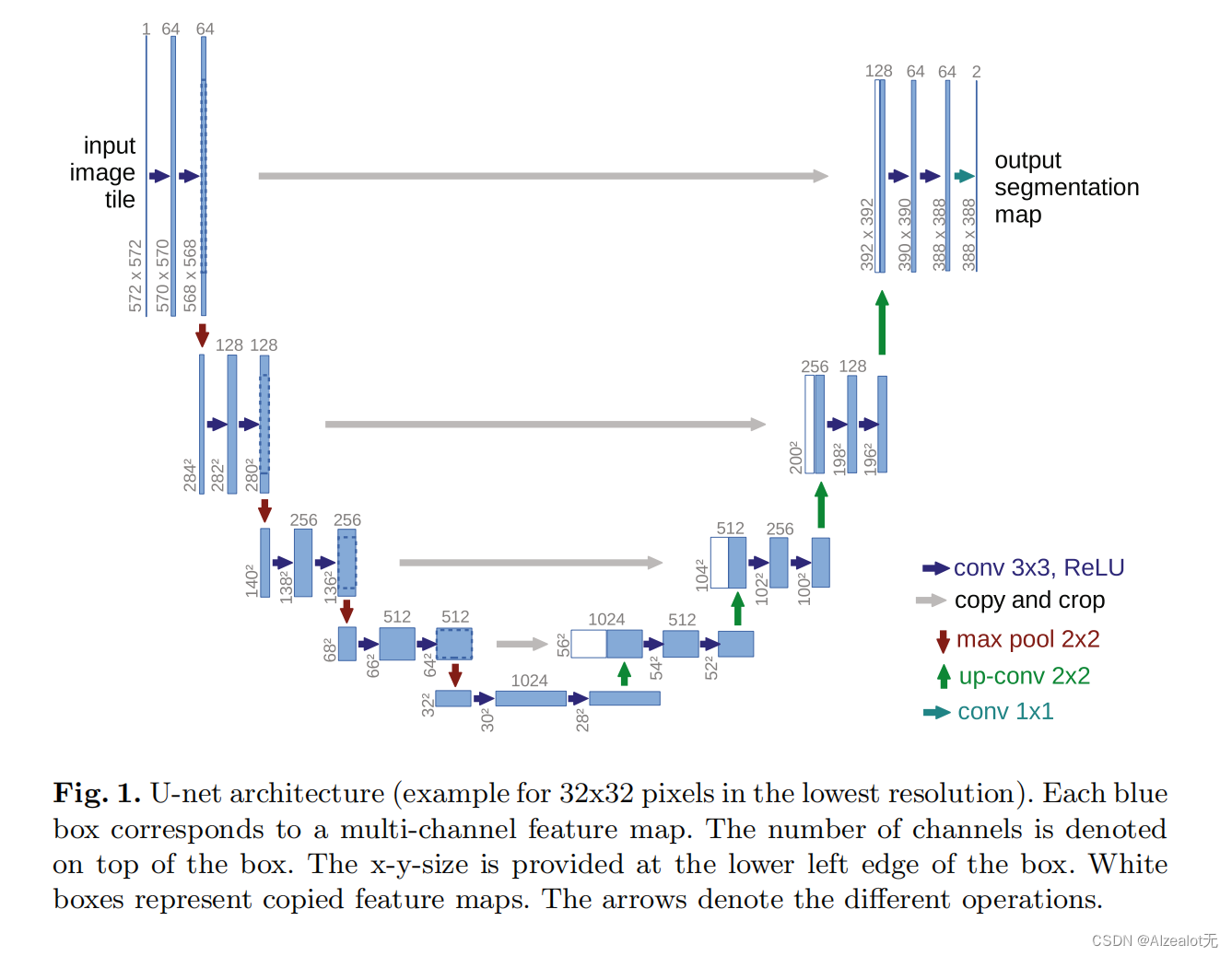

模型架构如上图,相较于目前的传统模型,这种古老又比较经典的模型是比较简单的。

蓝色矩形是图像特征的矩阵大小,都是等比例的。

左半部分是一个基于卷积的下采样过程,其中的主要操作是用卷积核大小为3的卷积然后再用ReLU函数激活,中间穿插红色的最大池化操作。

右半部分是一个基于上卷积的下采样操作(去卷积),在此过程中,特征矩阵的分辨率不断上升。

灰色的部分,将不同维度的特征进行复制和剪切,从而融合不同层的图片特征,从而是的模型能够看到比较丰富层次的图像特征。

最后一层有一个卷积核为1的卷积,做了特征映射,产生最后想要的类别数。

一共23个卷积操作,也正如题目所述,卷积神经网络。

其语义分割任务的训练是一个基于经过soft-max激活过的像素级别的cross-entropy loss。

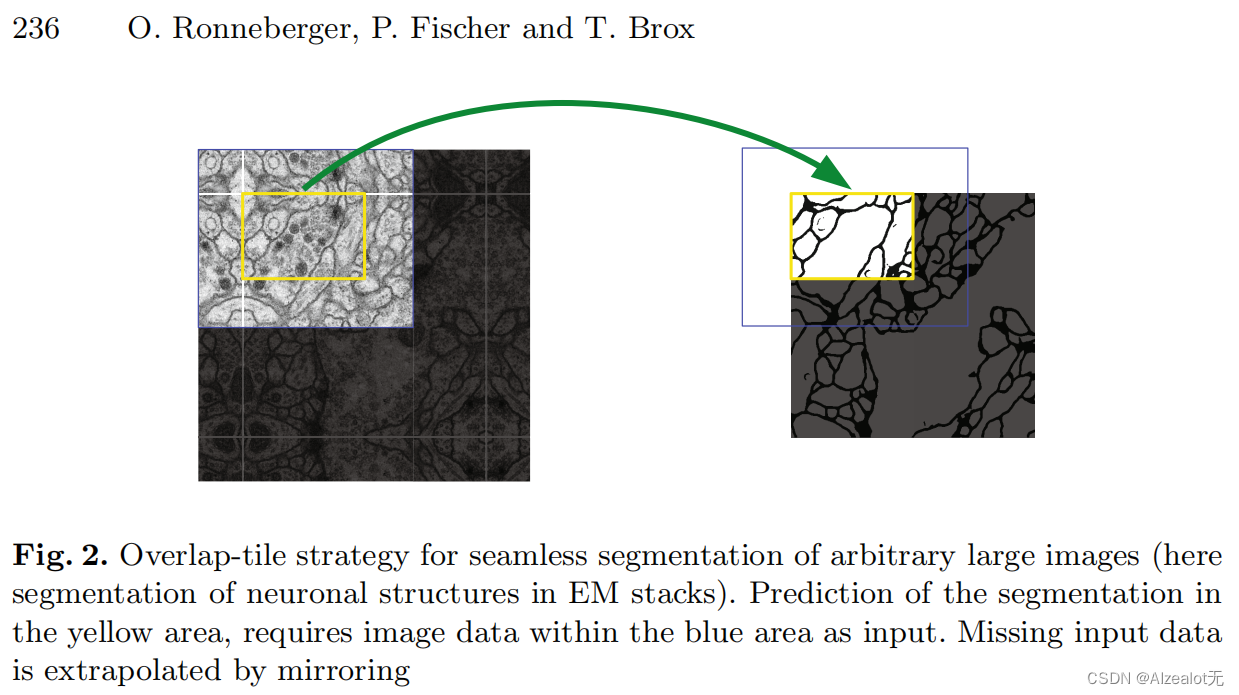

其中第一个重要的点,是在该网络结构中,上采样的扩张部分中使用的特征图通道数非常大,是的模型能够在特征数扩大的同时保留足够的环境信息(可以理解为图片的小局部的像素)。保留背景信息后,交联的图片间又能用复制的信息(白色的矩阵)进行外推。

通过上述的策略,模型能够对随机分割的较大医学图片进行无缝隙分割。

第二点,使用了数据增强来应对数据集量小的情况,这种数据增强被称为弹性变形:主要方法是使用10个像素点的高斯分布进行替换,然后将这些替换使用双三次插值(bicubic interpolation)进行计算,然后在下采样的结尾还有用到drop-out层。

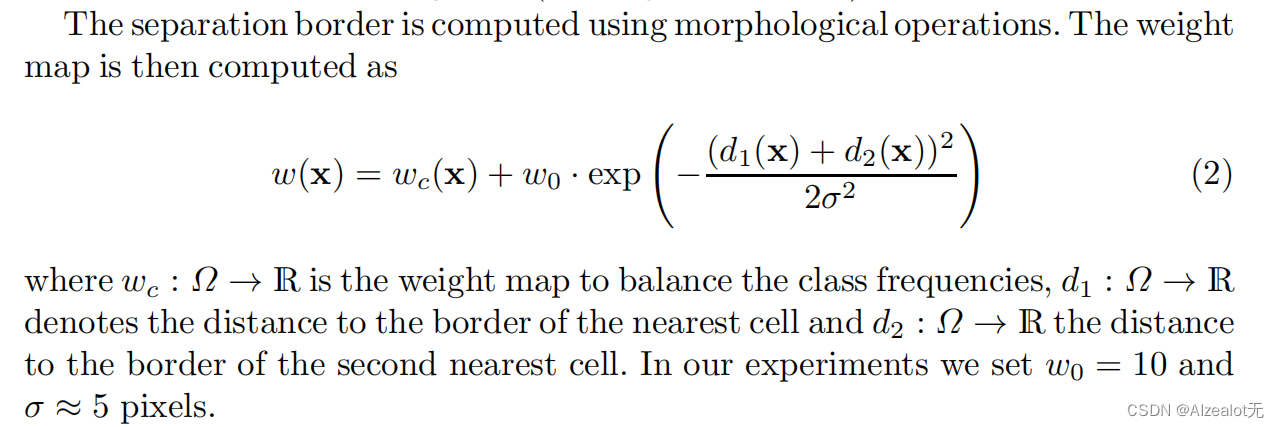

第三点,使用权重矩阵来应对物体重叠的情况。这种权重矩阵是根据待分割物体的情况进行提前计算的。

三、应用

U-Net的三个分割应用:

1.在电镜数据集下分割神经元结构:

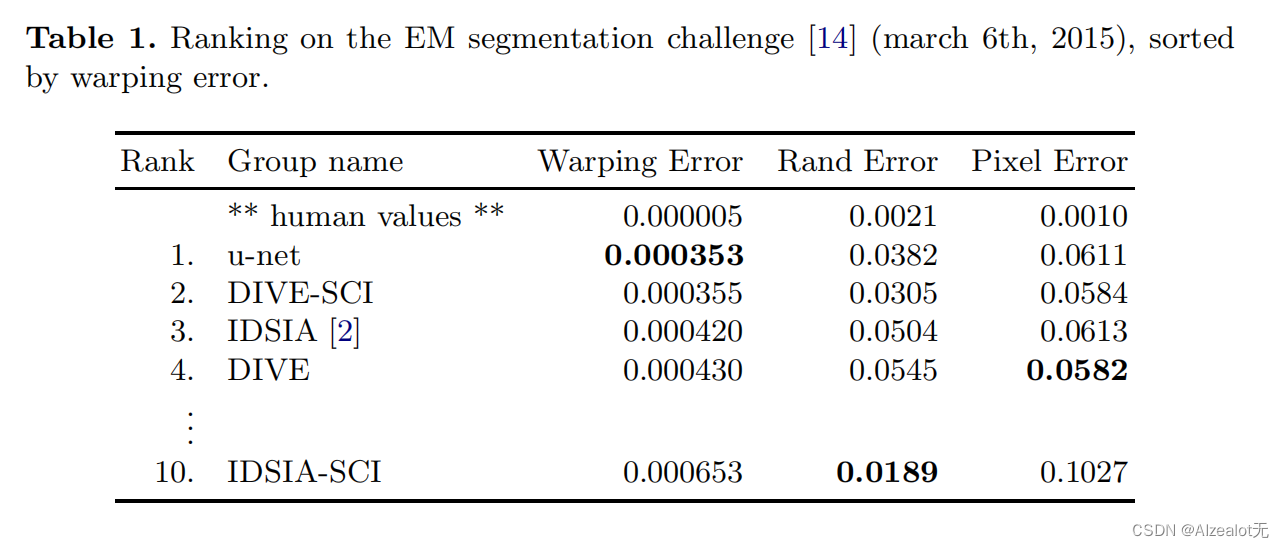

U-Net在EM segmentation challenge的打分指标上rank1

2.在光镜图片中的细胞分割:

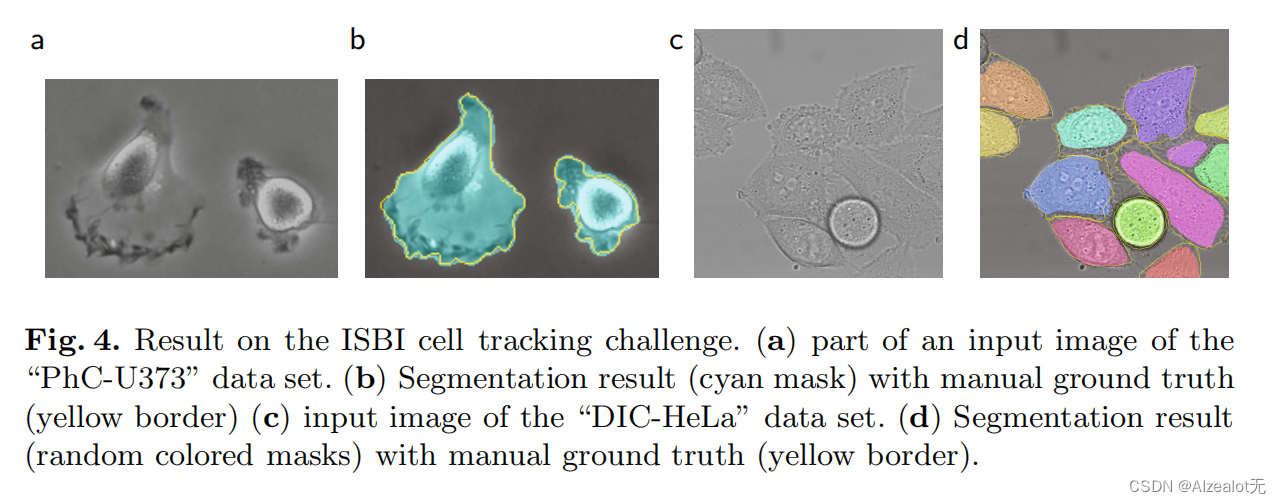

黄色是标注的ground truth,可以明显看出b为语义分割,d是实例分割.

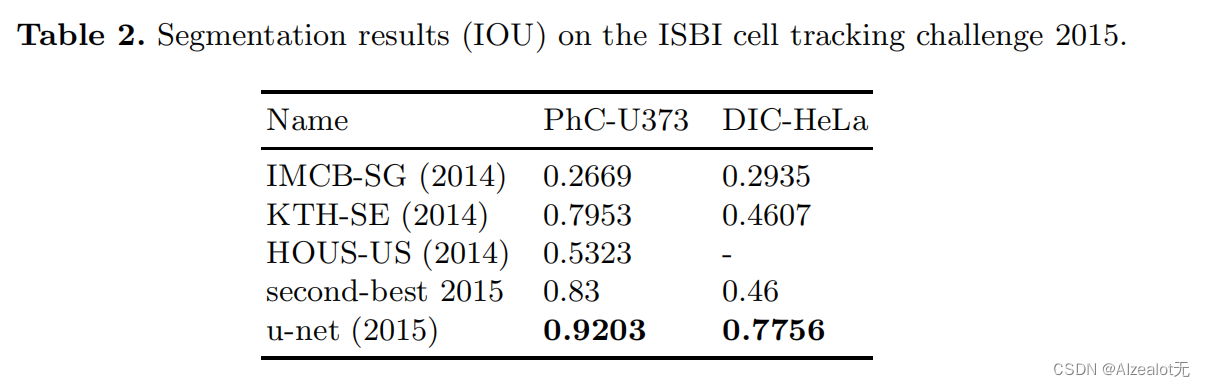

达到的单位一致指标IOU得分比较高

总而言之,这些挑战的数据集量很小,体现了此网络结构的核心主推点:将不同层的维度进行复制和剪切融合进行输入图片(在文章中被称为:以灵活变形进行数据增强)的一个增强的优势——不需要数据量很大,因此,此网络比较适用于医学图像分割。

DOI: 10.1007/978-3-319-24574-4 _ 28觉得内容有帮助的读者可以给个一键三连哦!

欢迎关注无神一起学AI