前言

-

特别是在计算机视觉领域,AI的潜能被无限放大,它使得机器能够“看见”并理解视觉世界,从而执行复杂的任务,如图像识别、目标检测和场景理解等。

-

很荣幸受邀参加CSDN关于昇腾新发布的香橙派AIpro的测评活动:

为此我将为大家介绍一款功能强大、易用性高的开发板——香橙派 AIpro

了解一下香橙派 AIpro:

-

这是一款基于NVIDIA Jetson Nano系列处理器的开发板,具有强大的AI计算能力。

-

它支持多种深度学习框架,如TensorFlow、PyTorch等,使开发者可以实现各种目标检测算法。

-

香橙 AIpro还配备了丰富的硬件接口,如HDMI、USB、GPIO等,方便与其他设备进行连接和通信。

快速上手香橙派AIpro:

镜像烧录快速教学:

--点击链接进入香橙派官网,下载烧录工具和镜像 (点击下面指引进行下载安装)

-

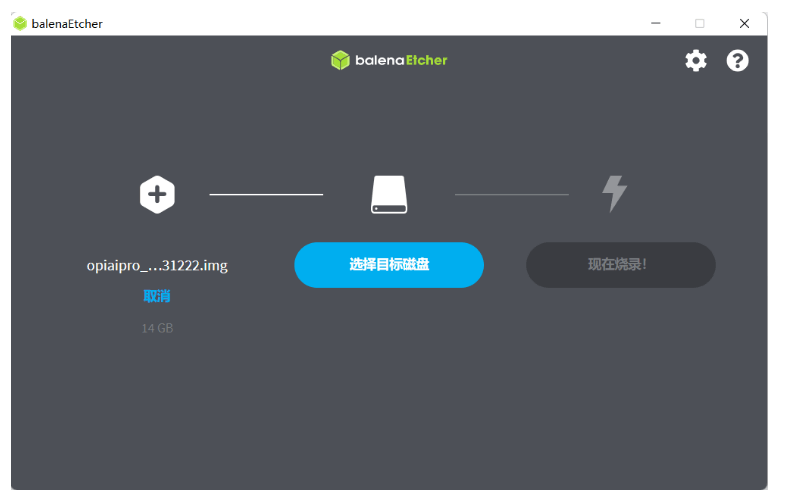

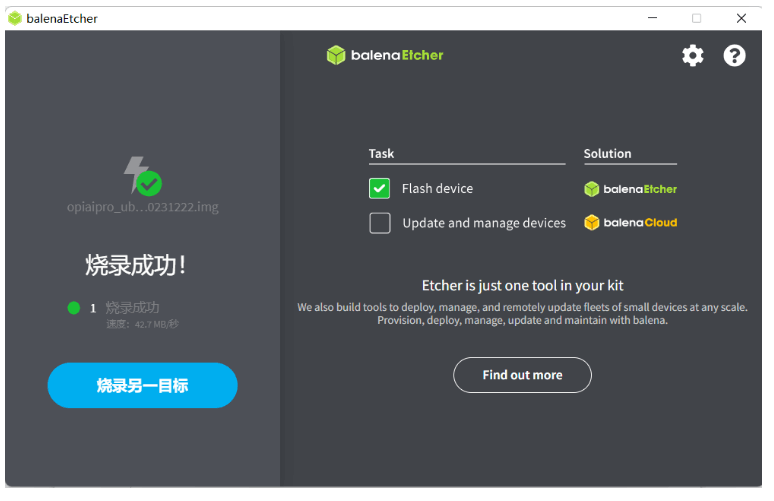

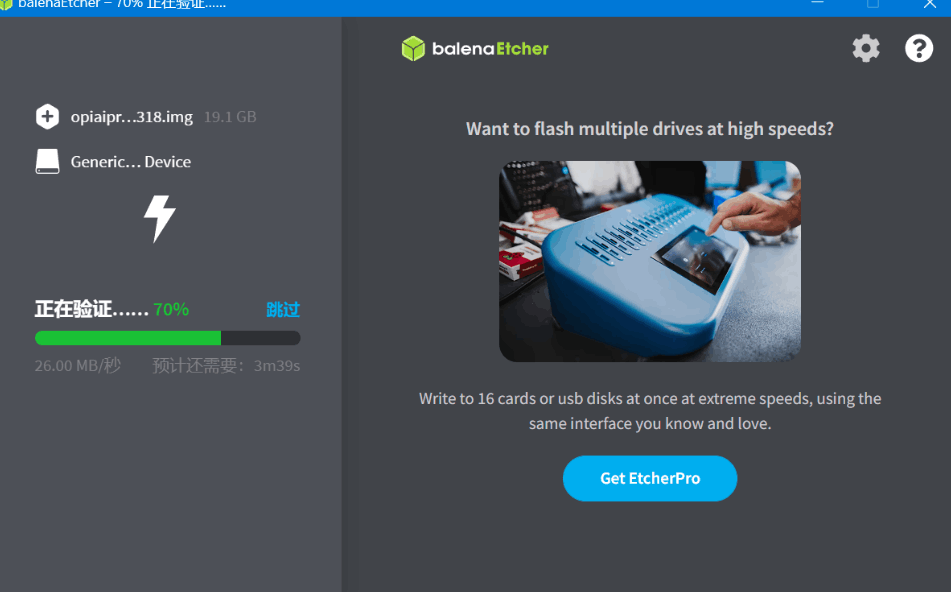

--安装烧录工具balenaEtcher:

(前期准备:将插入SD卡的读卡器插入PC准备烧录):

-

(依次点击--从文件烧录--选择目标磁盘--现在烧录!)

开发板启动

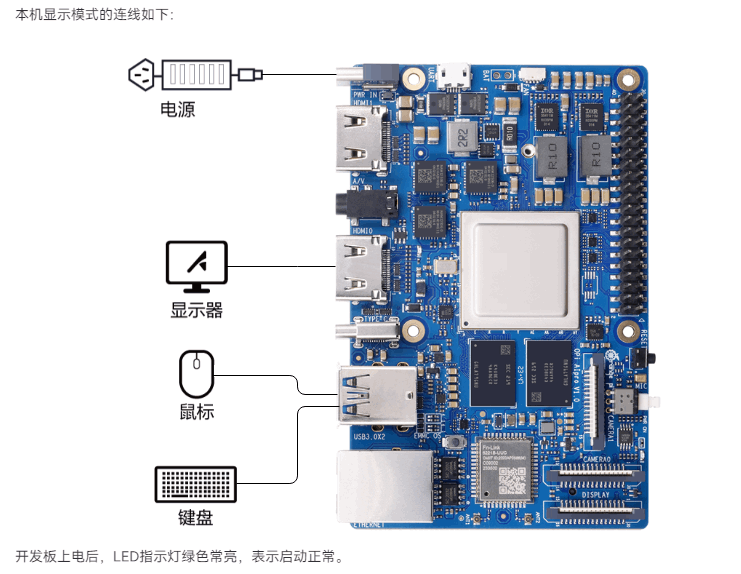

香橙派AIpro启动后支持用户通过远程登录模式或者本机显示模式登录开发板推理任务,此处可根据两种模式所需的配件,自行选择其中一种模式准备相关硬件即可。

本地显示模式:(推荐)

登录开发板:(密码默认为:Mind@123)

推理演示:

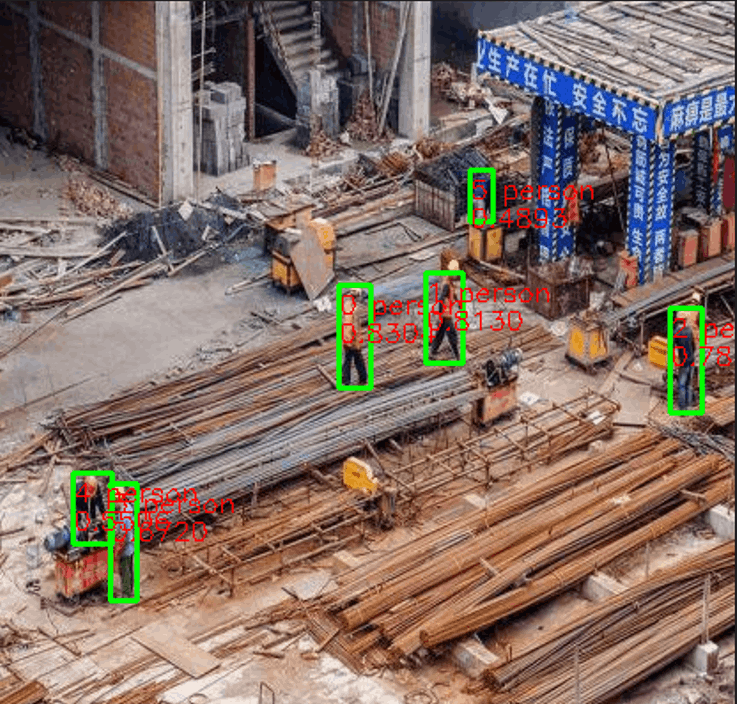

为了展示香橙派 AIpro的实际效果,我准备了一张图片(见下图):

在拍到的不太清晰的画面中包含了多名工人作业的情况。

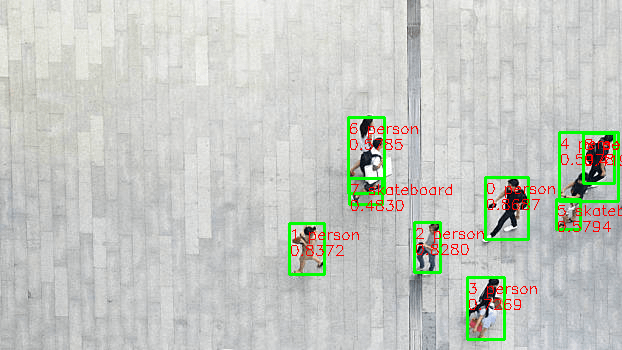

通过推理模型,我们可以清晰地看到每个人都被准确地识别出来,并用矩形框进行了标注(如下图)。

源码仓库下载:

-

打开终端进行git拉取:

git clone https://gitee.com/gaosongsong2023/yolov5_model.git #拉取离线模型 git clone https://gitee.com/gaosongsong2023/AI-TD #拉取案例

-

环境配置和依赖下载:

. /usr/local/Ascend/mx-.../set_env.sh #配置 apt-get update #更新 apt-get install eog #查看图片工具

-

准备测试图片编译源码:

cd AT-TD/ python main #执行脚本文件 vim main.py #修改测试图片样例,里面我写了注释

运行样例:

eog run.png #查看运行样例

香橙派AIpro的模型转换指南:

在进行模型转换之前,我们需要确保已经安装了必要的工具和依赖库。首先,确保你的系统已经安装了NVIDIA Jetson Nano开发套件,并具备基本的Python环境

接下来,安装TensorRT和ONNX-TensorRT库,这些库将帮助我们完成模型的转换和优化。

# 安装TensorRT sudo apt-get install nvidia-jetpack # 安装ONNX-TensorRT库 pip install onnx-tensorrt

模型转换步骤

-

准备原始模型文件:首先,你需要有一个已经训练好的深度学习模型文件,通常为ONNX格式。这个文件包含了模型的结构、权重等信息。

-

使用ONNX-TensorRT库进行模型优化:通过调用ONNX-TensorRT库中的函数,我们可以对原始模型进行优化,以提高其在特定硬件平台上的性能表现。

import onnx from onnx_tensorrt.backend import prepare # 加载原始模型文件 model = onnx.load("path/to/your/model.onnx") # 设置优化参数 optimization_params = {"input_shapes": [(1, 3, 224, 224)]} # 使用ONNX-TensorRT进行模型优化 optimized_model = prepare(model, **optimization_params)保存优化后的模型为OM格式:经过优化后,我们将得到一个适用于特定硬件平台的模型对象。现在,我们可以将其保存为OM格式的文件,以便在其他设备上使用。

# 保存优化后的模型为OM格式 optimized_model.save("path/to/save/optimized_model.om")体验总结:

-

在使用香橙派 AIpro的过程中,我也遇到了一些问题和挑战:例如,对于一些复杂的场景,如低光照、遮挡等,目标检测的准确性会有所下降。

-

AIpro不仅具有强大的计算能力和丰富的硬件接口,还提供了简单易用的编程环境,使得开发者可以轻松地实现各种目标检测应用。

-

随着AI技术的不断进步,越来越多的应用场景开始寻求集成机器视觉能力,从智能家居到工业自动化,从边缘计算到机器人导航,香橙派 AIpro都展现出了其独特的适用性和高效性。

-

Whether you are an AI technology researcher, hardware enthusiast, or innovative developer, Orange Pie AIpro will open up a new world full of infinite possibilities for you.

-

Let's follow the steps of this article, uncover the mysterious veil of Orange Pie AIpro, explore its capabilities, and apply it to your next innovative project.

-

-

-

-

-

-

-