一、PC配置

AMD Ryzen 5 3500X 6-Core Processor 3.59 GHz

内存 32.0 GB

Windows 10 企业版

2张N卡:

NVIDIA GeForce RTX 3060 Ti 8G显存

NVIDIA GeForce RTX 3060 12G显存

大容量硬盘:12T

二、使用wsl安装Ubuntu虚机

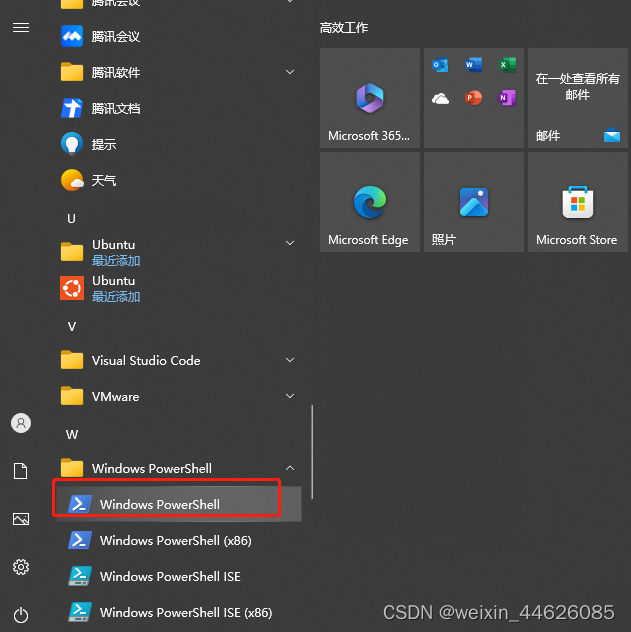

打开powershell

安装ubuntu 22.04.2 LTS

命令:wsl --install

如果遇到异常报错,先用命令wsl --update更新wsl

在unbuntu上面安装ssh

参考Ubuntu安装ssh服务详细过程[通俗易懂]-腾讯云开发者社区-腾讯云

三、安装Visual Studio Code

Visual Studio Code – 代码编辑器 | Microsoft Azure

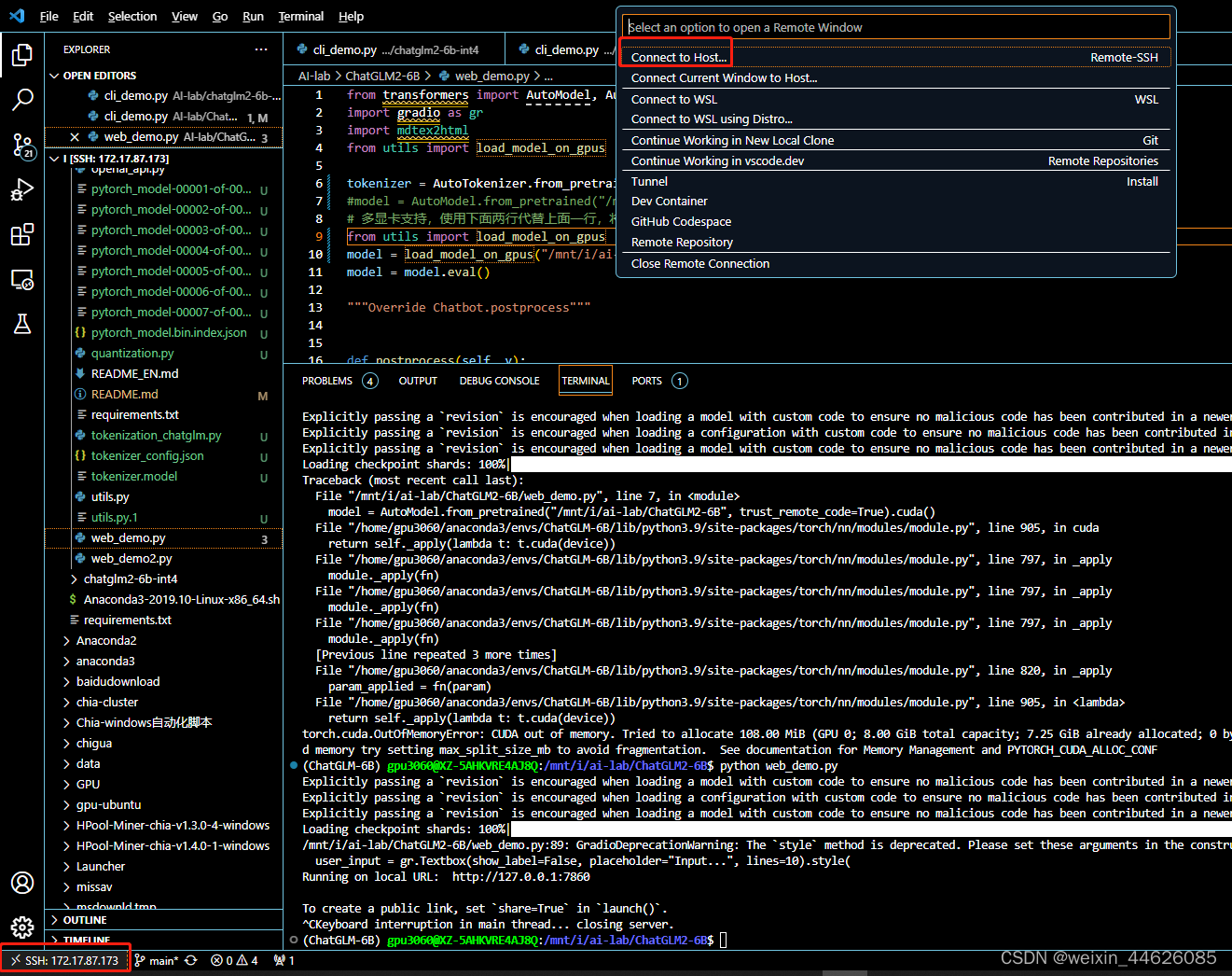

四、配置Visual Studio Code连接ubuntu

Visual Studio Code先安装如下插件

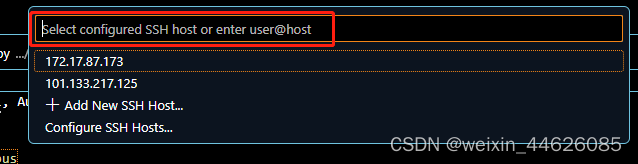

配置ssh

按照提示进行配置

例如:我的Ubuntu安装的时候用户名为gpu3060,密码为XXXXX,按提示一步步进行配置

五、安装conda

参考Ubuntu安装conda_没有金刚钻,也木有刷子的博客-CSDN博客

六、部署各种AI推理环境,以ChatGLM2-6B为例

ChatGLM2-6B 项目地址: https://github.com/THUDM/ChatGLM2-6B ChatGLM2-6B 是开源中英双语对话模型 ChatGLM-6B 的第二代版本,在保留了初代模型对话流畅、部署门槛较低等众多优秀特性的基础之上, ChatGLM2-6B 引入了如下 新特性: 更强大的性能 :基于 ChatGLM 初代模型的开发经验,我们全面升级了 ChatGLM2-6B 的基座模型。 ChatGLM2-6B 使用了 GLM 的混合目标函数,经过了 1.4T 中英标识符 的预训练与人类偏好对齐训练,评测结果显示,相比于初代模型, ChatGLM2-6B 在 MMLU ( +23% )、 CEval ( +33% )、 GSM8K ( +571% ) 、 BBH ( +60% )等数据集 上的性能取得了大幅度的提升,在同尺寸开源模型中具有较强的竞争力。 更长的上下文 :基于 FlashAttention 技术,我们将基座模型的上下文长度( Context Length )由 ChatGLM-6B 的 2K 扩展到了 32K ,并在对话阶段使用 8K 的上下文长度训 练,允许更多轮次的对话。但当前版本的 ChatGLM2-6B 对单轮超长文档的理解能力有限,我们会在后续迭代升级中着重进行优化。 更高效的推理 :基于 Multi-Query Attention 技术, ChatGLM2-6B 有更高效的推理速度和更低的显存占用:在官方的模型实现下,推理速度相比初代提升了 42% , INT4 量 化下, 6G 显存支持的对话长度由 1K 提升到了 8K 。 更开放的协议 :依照 Apache-2.0 协议开源, ChatGLM2-6B 模型的权重的使用则需要遵循 Model License 。 ChatGLM2-6B 权重对学术研究完全开放 ,在获得官方的书面许 可后,亦允许商业使用。 效果 相比于初代模型, ChatGLM2-6B 在多个维度的能力上,都取得了巨大的提升。 不足 :尽管模型在训练的各个阶段都尽力确保数据的合规性和准确性,但由于 ChatGLM2-6B 模型规模较小,且模型受概率随机性因素影响,无法保证输出内容的准确性, 且模型易被误导。部署推理

项目地址: https://github.com/THUDM/ChatGLM2-6B HuggingFace 地址: https://huggingface.co/THUDM/chatglm2-6b环境配置

首先需要下载本仓库: 1 git clone https://github.com/THUDM/ChatGLM2-6B 2 cd ChatGLM2-6B 创建一个新的 conda 环境,并安装环境依赖1 conda create -n chatglm2-6b python==3.9

2 pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple/

模型下载

可以使用官方提供的地址,也可以从 huggingface 下载 官方提供模型下载地址: https://cloud.tsinghua.edu.cn/d/674208019e314311ab5c/ HuggingFace 模型下载地址: https://huggingface.co/THUDM/chatglm2-6b 下载命令(需要提前安装 git-lfs ): 1 git clone https://huggingface.co/THUDM/chatglm2-6b.git 我下载到了 /mnt/i/ai-lab/ chatglm2-6b 路径下。git-lfs安装

安装 git-lfs 两种方式,一种是通过命令直接安装,一种是下载到本地后安装: 直接通过命令安装: https://codeleading.com/article/2815391430/ 1 # 先安装 git (如已安装可忽略) 2 sudo apt-get install git 3 # 安装 apt-get 源 4 curl -s https://packagecloud.io/install/repositories/github/git-lfs/script.deb.sh | sudo bash 5 # 安装 git-lfs 6 sudo apt-get install git-lfs 7 # 初始化 git-lfs 8 git lfs install 如果上面方式出现网速慢等情况,可以尝试本地安装: https://www.cnblogs.com/allmignt/p/12353756.html 这里安装好 git-lfs 后,直接用 git clone 命令完成下载。修改cli_demo.py相关参数

进入对应的conda环境里面运行

(base) gpu3060@XZ-5AHKVRE4AJ8Q:/mnt/i/AI-lab/ChatGLM2-6B$ conda info --envs

# conda environments:

#

base * /home/gpu3060/anaconda3

ChatGLM-6B /home/gpu3060/anaconda3/envs/ChatGLM-6B

chatglm2-6b /home/gpu3060/anaconda3/envs/chatglm2-6b

(base) gpu3060@XZ-5AHKVRE4AJ8Q:/mnt/i/AI-lab/ChatGLM2-6B$ conda activate chatglm2-6b

(chatglm2-6b) gpu3060@XZ-5AHKVRE4AJ8Q:/mnt/i/AI-lab/ChatGLM2-6B$

(chatglm2-6b) gpu3060@XZ-5AHKVRE4AJ8Q:/mnt/i/AI-lab/ChatGLM2-6B$ python cli_demo.py

Loading checkpoint shards: 100%|███████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████| 7/7 [00:58