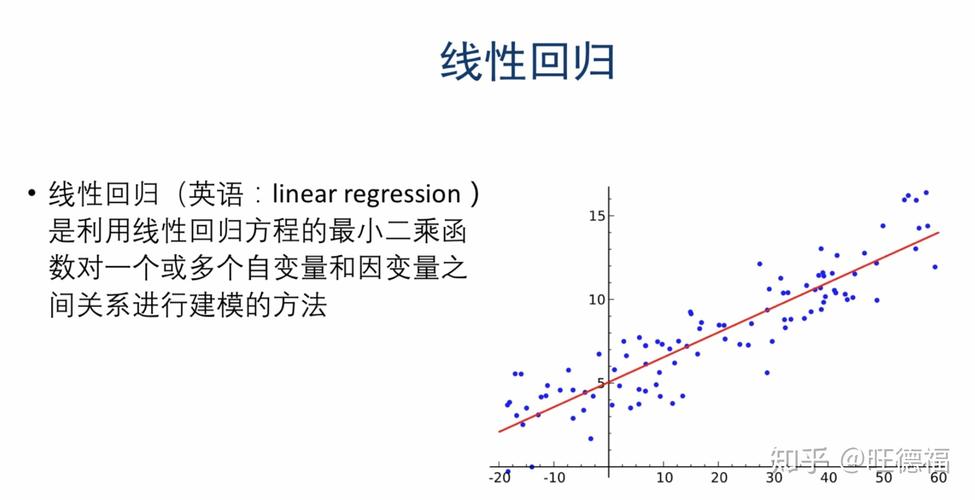

带有L2正则化的线性回归-岭回归

(图片来源网络,侵删)

岭回归,其实也是一种线性回归。只不过在算法建立回归方程时候,加上正则化的限制,从而达到解决过拟合的效果

API

(图片来源网络,侵删)

sklearn.linear_model.Ridge(alpha=1.0, fit_intercept=True,solver=“auto”, normalize=False)

- 具有l2正则化的线性回归

- alpha:正则化力度,也叫 λ

- λ取值:0~1 1~10

- solver:会根据数据自动选择优化方法

- sag:如果数据集、特征都比较大,选择该随机梯度下降优化

- normalize:数据是否进行标准化

- normalize=False:可以在fit之前调用preprocessing.StandardScaler标准化数据

- Ridge.coef_:回归权重

- Ridge.intercept_:回归偏置

Ridge方法相当于SGDRegressor(penalty=‘l2’, loss=“squared_loss”),只不过SGDRegressor实现了一个普通的随机梯度下降学习,推荐使用Ridge(实现了SAG)

sklearn.linear_model.RidgeCV(_BaseRidgeCV, RegressorMixin)