1. 背景介绍

1.1 人工智能的发展

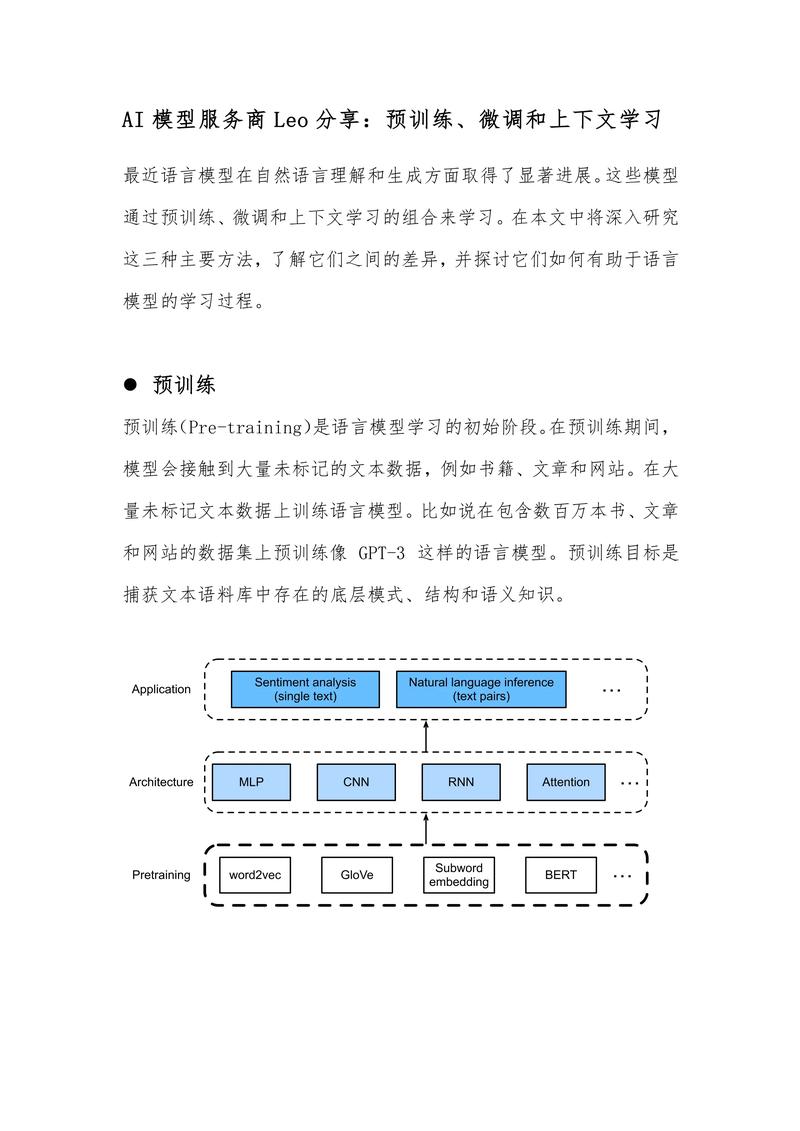

人工智能(AI)已经成为当今科技领域最热门的话题之一。从早期的专家系统、神经网络,到近年来的深度学习、强化学习,AI技术不断发展,取得了令人瞩目的成果。特别是在自然语言处理(NLP)领域,大型预训练语言模型(如GPT-3、BERT等)的出现,使得AI在理解和生成人类语言方面取得了革命性的突破。

(图片来源网络,侵删)

1.2 生成式预训练模型的挑战

尽管大型预训练语言模型在很多任务上表现出色,但它们仍然面临着一些挑战。其中之一就是如何在保持生成质量的同时,有效地控制生成内容的偏向性和安全性。为了解决这个问题,研究人员提出了一种名为“拒绝采样微调”(Rejection Sampling Fine-tuning,简称RSF)的技术。本文将详细介绍这一技术的原理、实现和应用,以及它对AI大语言模型的革命性影响。

2. 核心概念与联系

2.1 生成式预训练模型

生成式预训练模型(Generative Pre-trained Model,简称GPT)是一种基于Transformer架构的大型神经网络模型,通过在大量文本数据上进行无监督预训练,学习到丰富的语言知识。GPT模型可以在给定上下文的情况下,生成连贯且符合语法规则的文本。

(图片来源网络,侵删)

2.2 微调

微调(Fine-tuning)是指在预训练模型的基础上,通过在特定任务的标注数据上进行有监督训练,使模型能够适应该任务的需求。微调过程可以看作是对预训练模型的知识进行“调整”