最优模型选择的准则

选择的准则: AIC准则、BIC准则

1.AIC准则

概念:

AIC信息准则即Akaike information criterion,又称赤池信息准则。是衡量统计模型拟合优良性的一种标准,由日本统计学家赤池弘次创建和发展。它建立在熵的概念基础上,可以衡量所估计模型的复杂度和此模型拟合数据的优良性。

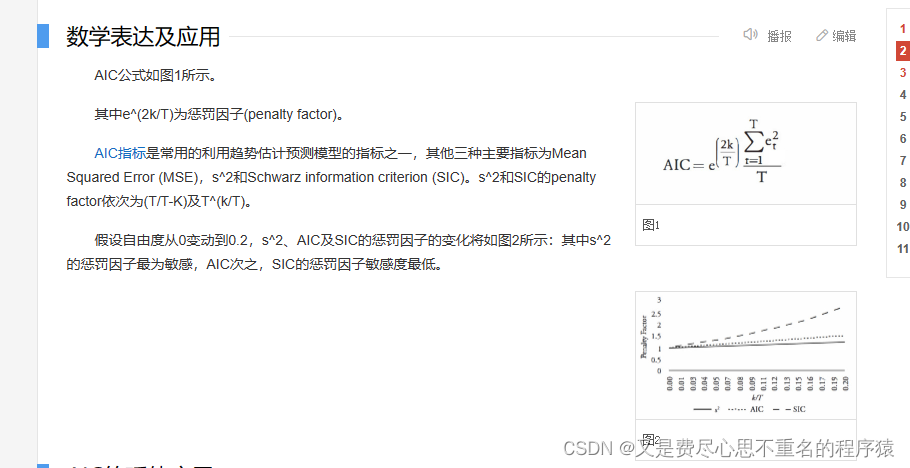

公式:

一般情况下,AIC表示为:AIC=2k-2ln(L)

注:k是参数的数量,L是似然函数

AIC鼓励数据拟合的优良性但是尽量避免出现过度拟合(Overfitting)的情况。所以优先考虑的模型应是AIC值最小的那一个。

2.BIC准则

概念:

BIC准则(BIC criterion)又称贝叶斯信息准则,与AIC准则(赤池信息准则)类似,用于模型的选择。很多参数估计问题均采用似然函数作为目标函数,当训练数据足够多时,可以不断提高模型精度,但是以提高模型复杂度为代价的,同时带来一个机器学习中非常普遍的问题——过拟合。 所以,模型选择问题在模型复杂度与模型对数据集描述能力(即似然函数)之间寻求最佳平衡。

公式:

BIC=kln(n)-2ln(L)

注:k是模型参数个数,n是样本的数量,L是似然函数

增加参数数量,也就是增加模型复杂度,会增大似然函数,但是也会导致过拟合现象。kln(n)惩罚项在样本数量较多的情况下可有效防止模型精度过高造成模型复杂度过高的问题,避免维度灾难现象。

维度灾难:

维度灾难是在数字图像处理中,对于已知样本数目,存在一个特征数目的最大值,当实际使用的特征数目超过这个最大值时,分类器的性能不是得到改善,而是退化。

对比:

AIC公式和BIC公式前半部分是一样的,后半部分是惩罚项,n较大时,kln(n)≥2k,所以,BIC相比AIC在大数据量时对模型参数惩罚得更多,导致BIC更倾向于选择参数少的简单模型。

参考文献:

百度百科

https://blog.csdn.net/ljzology/article/details/81287500?ops_request_misc=%257B%2522request%255Fid%2522%253A%2522167643030516782427411279%2522%252C%2522scm%2522%253A%252220140713.130102334…%2522%257D&request_id=167643030516782427411279&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2allsobaiduend~default-1-81287500-null-null.142v73pc_new_rank,201v4add_ask,239v1control&utm_term=%E6%9C%80%E4%BC%98%E6%A8%A1%E5%9E%8B%E9%80%89%E6%8B%A9&spm=1018.2226.3001.4187