1. 背景介绍

1.1 人工智能的崛起

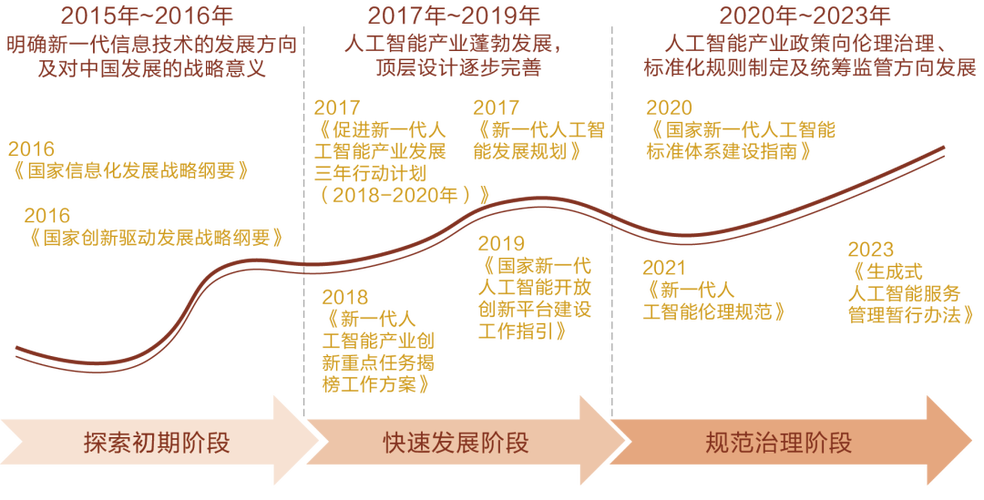

人工智能(AI)已经成为当今科技领域最热门的话题之一。随着计算能力的提升、大数据的普及和算法的不断创新,AI技术在各个领域取得了显著的突破。特别是近年来,深度学习技术的发展为人工智能的应用带来了革命性的变革。

(图片来源网络,侵删)

1.2 大语言模型的崛起

在人工智能领域,自然语言处理(NLP)是一个重要的研究方向。随着深度学习技术的发展,大型预训练语言模型(如GPT-3、BERT等)的出现,使得NLP领域取得了重大突破。这些大型预训练语言模型在各种NLP任务上表现出色,如机器翻译、文本分类、情感分析等,为人工智能在各个领域的应用提供了强大的支持。

1.3 商业机遇

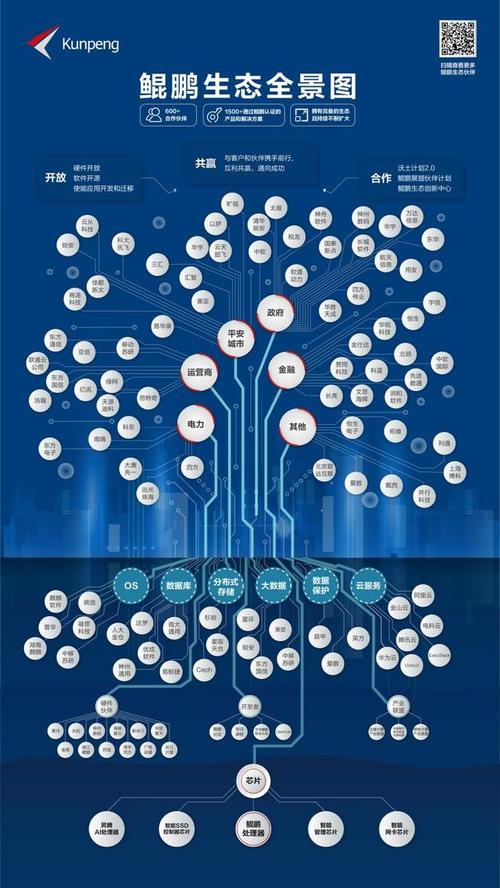

随着大型预训练语言模型的崛起,越来越多的企业和创业者开始关注这一领域的商业机遇。通过将大型预训练语言模型应用于各种场景,可以帮助企业提高效率、降低成本,同时为创业者提供了广阔的市场空间。本文将深入探讨大型预训练语言模型的核心概念、算法原理、实际应用场景等方面的内容,帮助读者抓住这一领域的商业机遇。

(图片来源网络,侵删)

2. 核心概念与联系

2.1 什么是大型预训练语言模型

大型预训练语言模型是一种基于深度学习技术的自然语言处理模型,通过在大量文本数据上进行预训练,学习到丰富的语言知识,从而在各种NLP任务上取得优异的表现。这些模型通常具有大量的参数,如GPT-3模型拥有1750亿个参数,使得它们具有强大的表达能力和泛化能力。

2.2 大型预训练语言模型与传统NLP方法的区别

与传统的NLP方法相比,大型预训练语言模型具有以下优势:

- 更强的表达能力:由于模型参数量巨大,使得大型预训练语言模型具有更强的表达能力,能够捕捉到更丰富的语言知识。

- 更好的泛化能力:通过在大量文本数据上进行预训练,大型预训练语言模型可以学习到更多的语言规律,从而在各种NLP任务上具有更好的泛化能力。

- 更高的效率:由于大型预训练语言模型已经学习到了丰富的语言知识,因此在进行具体任务时,只需要进行少量的微调,大大提高了模型的训练和部署效率。

2.3 大型预训练语言模型的关键技术

大型预训练语言模型的关键技术包括:

- 深度学习:大型预训练语言模型通常基于深度学习技术,如Transformer架构,使得模型具有强大的表达能力和泛化能力。

- 预训练与微调:通过在大量文本数据上进行预训练,模型可以学习到丰富的语言知识;在具体任务上进行微调,使得模型能够适应不同的应用场景。

- 自监督学习:大型预训练语言模型通常采用自监督学习方法进行训练,如Masked Language Model(MLM)和Causal Language Model(CLM),使得模型能够在无标签数据上进行学习。

3. 核心算法原理和具体操作步骤以及数学模型公式详细讲解

3.1 Transformer架构

大型预训练语言模型通常基于Transformer架构。Transformer是一种基于自注意力机制(Self-Att