1. 背景介绍

1.1 人工智能的崛起

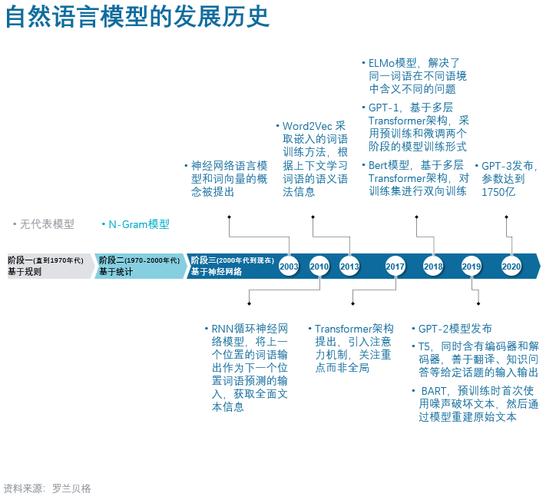

随着计算机技术的飞速发展,人工智能(Artificial Intelligence,AI)已经成为了当今科技领域的热门话题。从早期的图灵测试到现在的深度学习,人工智能已经取得了令人瞩目的成就。在这个过程中,自然语言处理(Natural Language Processing,NLP)作为人工智能的一个重要分支,也得到了广泛的关注。

1.2 自然语言处理的挑战

自然语言处理的目标是让计算机能够理解和生成人类语言。然而,由于人类语言的复杂性和多样性,这一目标一直以来都是具有挑战性的。为了解决这个问题,研究人员开始尝试使用机器学习方法,特别是深度学习方法来处理自然语言任务。在这个过程中,大型语言模型(Large Language Models,LLMs)应运而生。

2. 核心概念与联系

2.1 语言模型

语言模型(Language Model,LM)是一种用于描述自然语言序列概率分布的数学模型。简单来说,语言模型就是用来计算一个句子或者一个词序列出现概率的模型。

2.2 大型语言模型

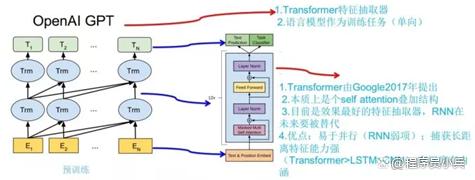

大型语言模型是指参数量非常庞大的语言模型。这些模型通常使用深度学习方法进行训练,如循环神经网络(Recurrent Neural Networks,RNNs)、长短时记忆网络(Long Short-Term Memory,LSTM)和Transformer等。随着计算能力的提升和大量文本数据的可用性,大型语言模型的表现越来越好,甚至在某些任务上超过了人类的表现。

2.3 预训练与微调

大型语言模型的训练通常分为两个阶段:预训练(Pre-training)和微调(Fine-tuning)。在预训练阶段,模型在大量无标签文本数据上进行训练,学习到通用的语言表示。在微调阶段,模型在特定任务的标注数据上进行训练,以适应特定任务的需求。

3. 核心算法原理和具体操作步骤以及数学模型公式详细讲解

3.1 循环神经网络

循环神经网络(RNN)是一种用于处理序列数据的神经网络。RNN的核心思想是在网络中引入循环连接,使得网络能够处理任意长度的序列。RNN的基本结构如下:

$$ h_t = \sigma(W_{hh}h_{t-1} +