文章目录

- 1. 运动感知类与环境感知类传感器

- 2. 为什么需要这么多传感器?

- 2.1 从需求侧分析

- 2.2 从供给侧分析

- 3. 多传感器硬件系统的设计思路

- 4. 多传感器系统的时序闭环

- 4.1 传感器时钟闭环构建

- 4.2 成像同步机制

- 5. 多传感器融合算法

- 5.1 多传感器融合问题建模

- 5.2 后融合

- 5.2.1 后融合需要解决的问题

- 5.3 前融合

- 5.3.1 前融合需要解决的问题

- 5.3.2 数据融合、特征融合与目标融合

- 5.4 实际的多传感器融合的感知系统

- 6. 状态空间表示法

- 6.1 动态系统的数学表达

- 6.2 线性定常系统的数学表达

- 6.3 状态空间分析方法下多传感器融合问题的数学描述

- 7. 卡尔曼滤波与扩展卡尔曼滤波

- 7.1 基于卡尔曼滤波的感知融合

- 7.1.1 卡尔曼滤波的特点

- 7.1.2 传感器信息与模型知识的融合

- 7.1.3 KF卡尔曼滤波器的算法结构

- 7.1.4 卡尔曼滤波的启示与局限性

- 7.2 基于扩展卡尔曼滤波的感知融合

- 7.2.1 非线性系统的多传感器融合

- 7.2.2 EKF扩展卡尔曼滤波器的算法结构

- 7.2.3 扩展卡尔曼滤波的启示与局限性

- 8. Apollo文心大模型在自动驾驶中的应用

- 声明

自动驾驶系统由环境感知、规划、决策、控制等几个模块组成,其中环境感知需要用到诸如摄像头、毫米波雷达、激光雷达等传感设备来获取周围环境的信息。不同种的传感器有着不同的优势与缺陷,为了使感知层获得的信息更为丰富、准确,通常需要将不同的传感器进行融合。本文着重介绍多传感器融合的概念与相关知识,不具体介绍技术细节。

1. 运动感知类与环境感知类传感器

自动驾驶中的传感器一般分为运动感知类传感器与环境感知类传感器。

运动感知类传感器主要用以解决自动驾驶中的定位与建图问题。常见的传感器有全球定位系统(GNSS,Global Navigation Satellite System)、RTK(Real-Time Kinematic)、惯性传感器IMU(IMU,Inertial Measurement Unit)、轮速计(Wheel Speedometer)、激光雷达(LiDAR,Light Detection and Ranging)、相机(Camera)。

环境感知类传感器在自动驾驶中一般用于感知目标。常见的传感器有激光雷达(LiDAR,Light Detection and Ranging)、相机(Camera)、毫米波雷达(RaDAR,Radio Detection and Ranging,或者millimeter wave radar)、超声波雷达(ultrasonic radar)。

从传感器的功能角度看,上述两个方面的传感问题都需要用到多传感器融合。

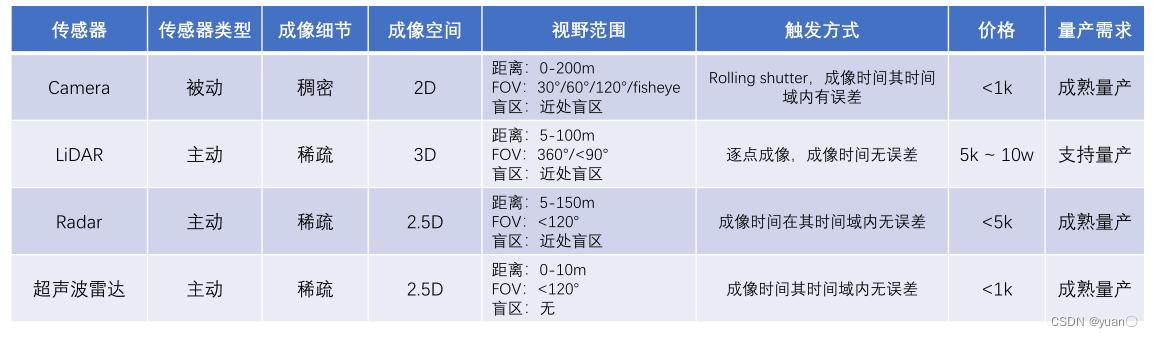

下面是对常见传感器的总结。

下面总结了传感器如何相互配合

- 多种电磁波与机械波配合

- 被动传感器与主动传感器配合

- 稀疏传感器与密集传感器搭配,2D与3D配合远中近距离均适合

- FOV可灵活搭配,可有效区分重点区域

- 时间戳误差可控,感知的维度各有所长

- 均已量产,LiDAR虽 成本高使用受限,但发展快

2. 为什么需要这么多传感器?

2.1 从需求侧分析

自动驾驶系统需要考虑多方面的因素:天气、光照条件、距离、维度及精度与系统级要求。除此之外,对于传感器,成本可控、满足车规要求也是十分重要的。

天气 光照条件 距离 维度及精度 系统级要求 晴天 白天 盲区(0-2m) 六自由度观测 无漏检 雨天 黄昏 近距离(2-40m) 速度/加速度/角速度等 无误检 雾天 黑夜 中距离(40-80m) 时间误差{{\left[ {\begin{array}{ccccccccccccccc}R&t\\0&1\end{array}} \right]}_t},\left\{ {landmark{s_0},...,landmark{s_t}} \right\}} \right\} G(sensort)→{[R0t1]t,{landmarks0,...,landmarkst}}x,y,z,l,w,h,vx,vy,vz,...}scenariost,scenario={class,zone}...