ELK如何分析nginx access日志及elk收集nginx日志

ELK(Elasticsearch、Logstash和Kibana)是一个流行的开源日志管理平台,可以帮助我们有效地收集、存储、分析和可视化各种类型的日志数据。在这篇文章中,我们将探讨如何使用ELK来分析nginx access日志,并且介绍如何配置ELK以收集nginx日志。

Elasticsearch简介

Elasticsearch是一个基于Lucene的分布式搜索和分析引擎,它可以用于存储和检索大量结构化和非结构化数据。它提供了强大的全文搜索功能,并支持实时数据分析。在ELK堆栈中,Elasticsearch用于存储和索引日志数据。

Logstash简介

Logstash是一个用于收集、处理和转发日志和事件数据的开源工具。它可以从多个来源收集日志数据,并将其转换为统一的格式,然后将其发送到目标位置。在ELK堆栈中,Logstash用于收集和解析nginx access日志。

Kibana简介

Kibana是一个用于可视化和分析日志数据的开源工具。它提供了一个直观的用户界面,可以通过创建仪表板、图表和报表来展示和分析数据。在ELK堆栈中,Kibana用于可视化nginx access日志的分析结果。

如何分析nginx access日志

要分析nginx access日志,我们需要使用Logstash来收集和解析日志数据,并将其发送到Elasticsearch进行存储和索引。下面是一些步骤来配置Logstash:

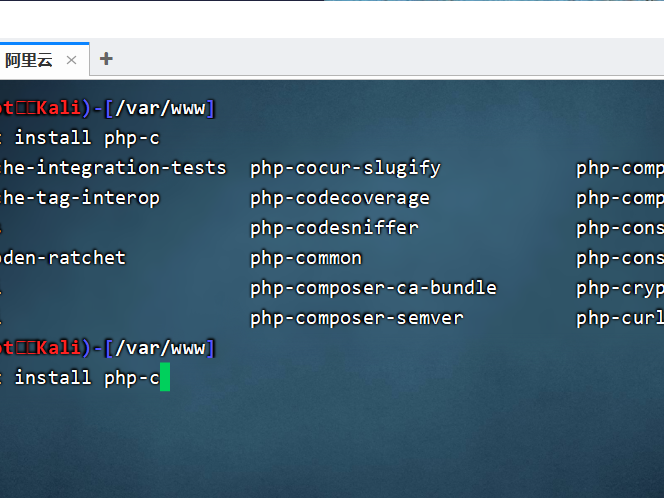

1. 安装Logstash并启动服务。

2. 创建一个新的Logstash配置文件,例如"nginx.conf"。

3. 在配置文件中定义输入插件,以便从nginx access日志文件中读取数据。可以使用filebeat作为输入插件,它可以监视日志文件的变化并将数据发送给Logstash。

4. 使用grok过滤器来解析nginx access日志中的字段。Grok是一个强大的模式匹配工具,可以将未结构化的文本转换为结构化数据。

5. 配置输出插件,将解析后的日志数据发送到Elasticsearch进行存储和索引。

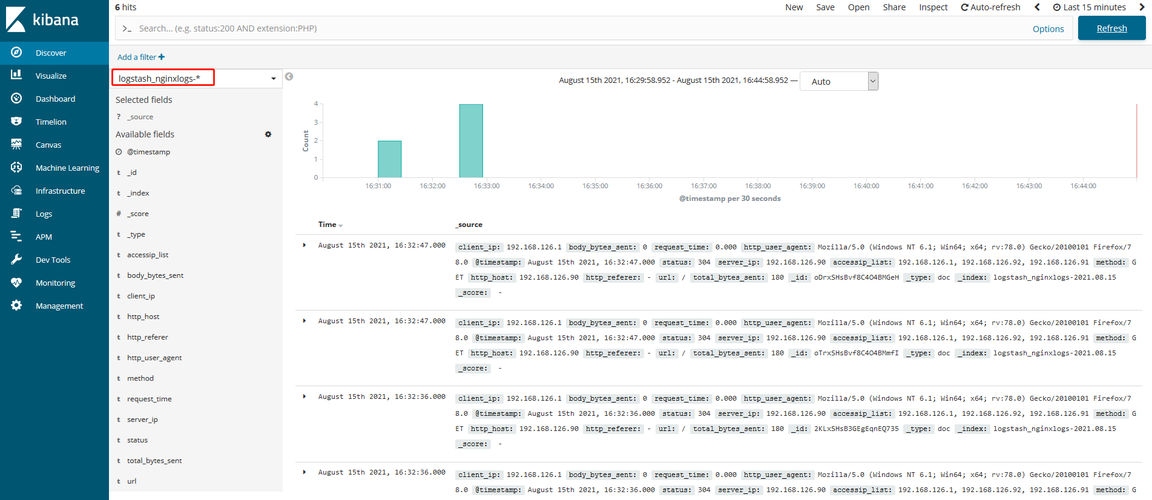

完成以上步骤后,Logstash将开始收集、解析和发送nginx access日志数据到Elasticsearch。接下来,我们可以使用Kibana来可视化和分析这些数据。

ELK收集nginx日志

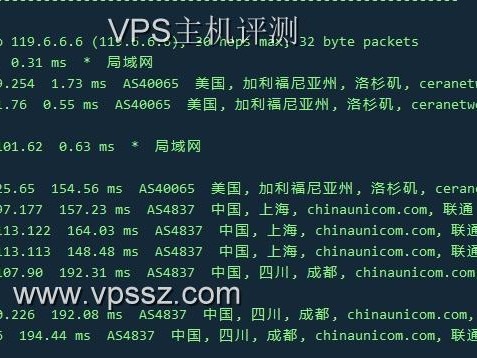

要使用ELK收集nginx日志,我们需要安装和配置Filebeat来监视nginx日志文件,并将其发送给Logstash进行处理。下面是一些步骤来配置Filebeat:

1. 安装Filebeat并启动服务。

2. 创建一个新的Filebeat配置文件,例如"nginx.yml"。

3. 在配置文件中定义输入插件,以便监视nginx日志文件。可以指定日志文件的路径、格式等信息。

4. 配置输出插件,将日志数据发送给Logstash进行处理。

完成以上步骤后,Filebeat将开始监视nginx日志文件,并将其发送给Logstash进行处理。Logstash将负责解析和转换日志数据,并将其发送到Elasticsearch进行存储和索引。

总结

ELK是一个功能强大的日志管理平台,可以帮助我们分析和可视化各种类型的日志数据。通过使用Logstash来收集和解析nginx access日志,并使用Elasticsearch和Kibana来存储和分析这些数据,我们可以获得有关nginx访问模式、性能和安全性等方面的深入洞察。同时,通过配置Filebeat来收集nginx日志,我们可以实现实时的日志收集和处理。

最多5个TAGS: ELK, Nginx, 日志分析, 日志收集, 可视化