引言

在数字多媒体的时代,人们对于互动性和个性化视频内容的需求不断增长。阿里巴巴的EMO(Emote Portrait Alive)模型,作为一项前沿的人工智能技术,正引领着这一领域的革新之路。

EMO模型概述

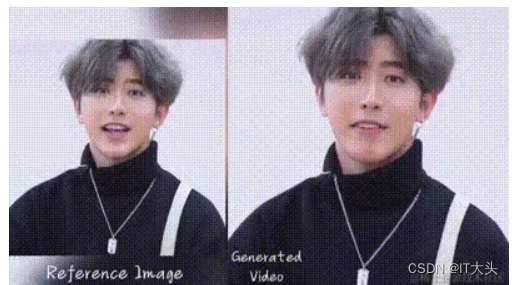

EMO模型是阿里巴巴智能计算研究院通过深度学习技术研发的一款强大的视频生成工具。它能够仅凭一张静态图片和一段语音,生成具有丰富表情和真实头部动作的视频,从而打破传统视频制作的局限。

阿里发布了一个大模型的展示页面,提出了一个名叫 EMO(Emote Portrait Alive) 的大模型,一种富有表现力的音频驱动的基于人物肖像生成视频的框架。具体来讲就是,输入单个参考人物肖像图像和语音(例如讲话或者唱歌等),可以生成具有丰富的面部表情和各种头部姿势的声音头像视频,同时可以根据输入视频的长度生成任意持续时间的视频

核心技术与创新

模型采用 stable diffusion 这一当下的主流框架作为整个模型基础框架,整个框架主要由两个阶段组成:在称为 Frames Encoding 这一初始阶段,ReferenceNet 用于从 reference image 和 motion frames 中提取特征。然后进入 Diffusion Process 阶段,模型输入不仅包括上面的两种特征,还需要预训练的 audio encoder 处理的音频特征,speed encoder 处理的头部速度嵌入,还有照片中的面部区域掩码特征以及多帧噪声集,通过主干网络的反复去燥操作完美控制面部图像的生成。

在主干网络中,除了 Self-Attention ,还应用了两种形式的注意力机制:Reference-Attention 和 Audio-Attention 。这两种机制分别对于保留角色的身份和调节角色的动作至关重要。此外 Temporal Modules 用于操纵时间维度,并调整运动速度。

EMO的核心在于独特的Audio2Video扩散模型,这项技术实现了音频信号到面部表情以及头部姿势的自然映射。通过深度神经网络,EMO捕捉到语音中的情感和语言细节,并将其转化为逼真的人脸动画。

效果展示

Character: KUN KUN:谁说我们坤坤没有实力,这就是证据,看看这 RAP 饶舌,一字不差,吐字清晰,真的是溜得飞起【六到已经翻白眼】~~

应用场景

EMO的应用范围广泛,提供了多元化的解决方案,以适应不同的业务需求和创作场景。

娱乐产业

在电影、游戏和虚拟偶像产业中,EMO可以创造出栩栩如生的角色,增强用户的沉浸感和互动体验。

教育领域

EMO模型能够辅助教育工作者快速制作出富有表现力的教学材料,使得在线课程更加生动有趣。

虚拟代言

商家可以利用EMO创建专属的虚拟代言人,节约成本的同时,还能提供更具吸引力的广告内容。

未来展望

随着AI技术的不断发展,EMO展现出了巨大的潜力和多样化的发展方向。