1. 背景介绍

1.1 人工智能的崛起

随着计算机技术的飞速发展,人工智能(AI)已经成为了当今科技领域的热门话题。从自动驾驶汽车到智能家居,AI已经渗透到了我们生活的方方面面。在这个过程中,AI大语言模型作为人工智能领域的重要组成部分,得到了广泛的关注和研究。

(图片来源网络,侵删)

1.2 大语言模型的兴起

大语言模型是一种基于深度学习的自然语言处理技术,通过对大量文本数据进行训练,可以生成具有一定语义和语法结构的文本。近年来,随着计算能力的提升和数据量的增加,大语言模型的性能得到了显著提升。例如,OpenAI的GPT-3模型已经可以生成非常接近人类水平的文本。

然而,随着大语言模型的规模越来越大,模型维护的难度也在不断增加。本文将重点介绍AI大语言模型的模型维护,包括核心概念、算法原理、具体实践、应用场景等方面的内容。

(图片来源网络,侵删)

2. 核心概念与联系

2.1 语言模型

语言模型是一种用于描述自然语言序列概率分布的数学模型。给定一个词序列,语言模型可以计算这个序列出现的概率。语言模型的训练目标是最大化训练数据上的概率,从而使模型能够生成更符合实际语言规律的文本。

2.2 大语言模型

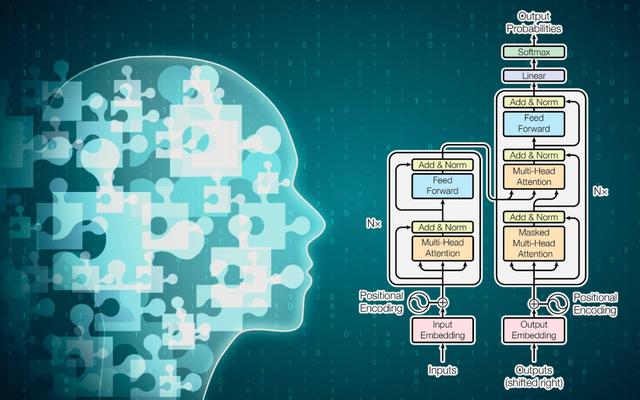

大语言模型是指参数量非常庞大的语言模型。这些模型通常使用深度学习技术,如Transformer架构,对大量文本数据进行训练。随着模型规模的增加,大语言模型可以生成更加接近人类水平的文本。

2.3 模型维护

模型维护是指在模型部署后,对模型进行监控、更新和优化的过程。对于AI大语言模型来说,模型维护包括以下几个方面:

- 模型监控:监控模型在实际应用中的性能,如准确率、响应时间等。

- 模型更新:根据新的数据和需求对模型进行迭代更新。

- 模型优化:通过调整模型参数、结构等方法提升模型性能。

- 模型安全:确保模型在部署过程中的安全性,防止恶意攻击和数据泄露。

3. 核心算法原理和具体操作步骤以及数学模型公式详细讲解

3.1 Transformer架构

Transformer是一种基于自注意力机制(Self-Attention)的深度学习架构,广泛应用于大语言模型的训练。Transformer的核心思想是通过自注意力机制捕捉输入序列中的长距离依赖关系,从而提升模型的表达能力。

Transf